Qu'est-ce qu'AWS Bedrock ?

Amazon Bedrock est une plateforme de services gérés lancée par Amazon Web Services AWS en 2023, conçue pour simplifier la création d'applications d'IA générative. En utilisant des modèles de base pré-entraînés provenant de grandes entreprises d'IA telles que Cohere, Anthropic et Meta, Bedrock permet aux développeurs d'intégrer facilement des capacités d'IA avancées dans leurs applications sans avoir à gérer l'infrastructure sous-jacente.

AWS Bedrock est un bon moyen de centraliser l'accès à plusieurs modèles de base et de tout conserver au sein d'AWS.

Pour aller plus loin : Accélérer sa migration cloud

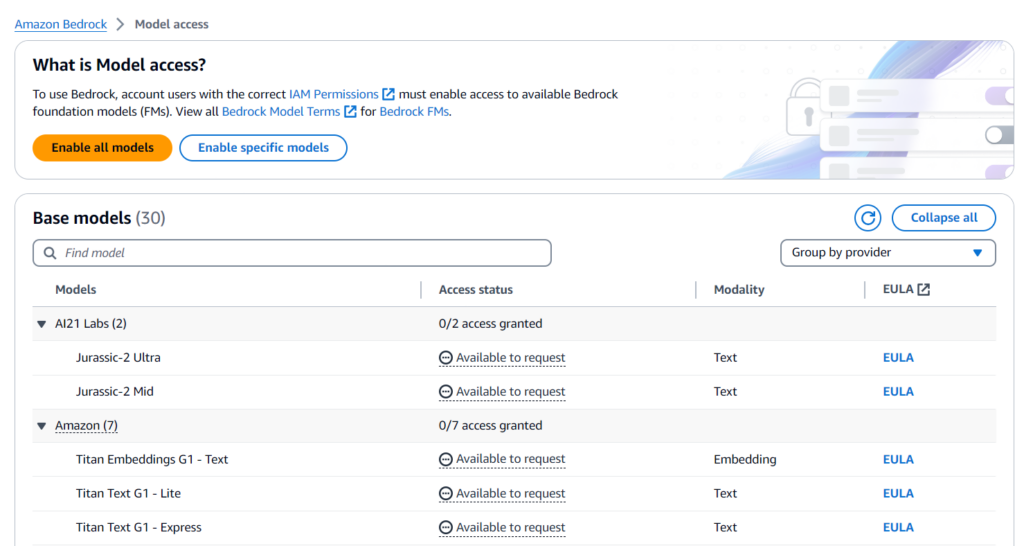

Choix des modèles dans AWS Bedrock

Vous pouvez choisir d'activer l'accès à tous les modèles ou seulement à certains d'entre eux, pour cette démo nous n'activerons et n'utiliserons que le Llama 3 70b Instruct (puisqu'il s'agit d'un modèle d'Instruct et non de Chat, il n'est pas bien adapté au style de conversation Questions/Réponses, mais mieux pour suivre des instructions, pour résumer un texte par exemple) qui est le dernier modèle le plus puissant de Meta, et le top 8 actuel sur le tableau de classement LMsys.

L'activation du modèle est automatique, il suffit de le sélectionner et de l'activer. Pour les modèles anthropiques, vous devrez décrire votre cas d'utilisation avant d'activer le modèle.

Le pricing d'AWS Bedrock

Pour notre modèle spécifique dans cette démo, Llama 3 70B, le pricing d'AWS Bedrock est le suivant :

- Entrée : $2,65 / 1 million de jetons*

- Sortie : $3,5 / 1 million de jetons*

A noter qu'un million de jeton équivaut à 750.000 mots.

Démonstration de l'outil AWS Bedrock pour l'IA Générative

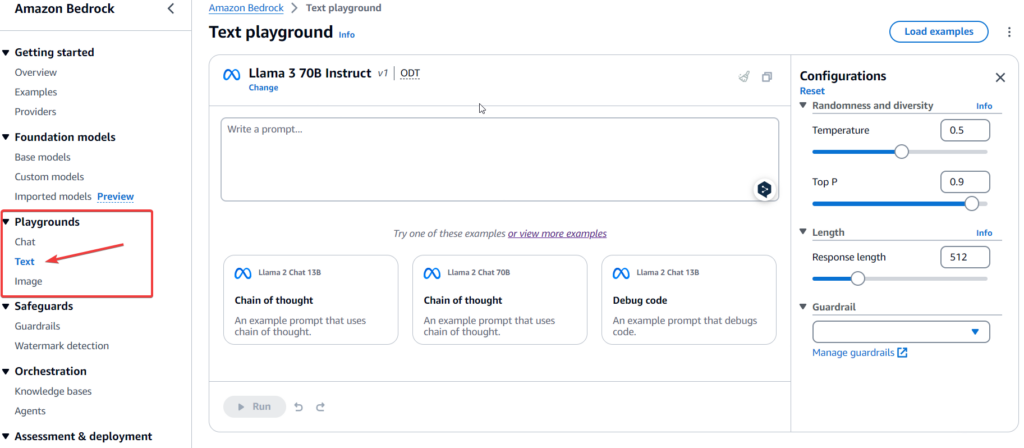

Pour faire un premier test rapide avec le modèle, nous pouvons aller dans "Playgrounds" et sélectionner Text (puisque nous utilisons un LLM).

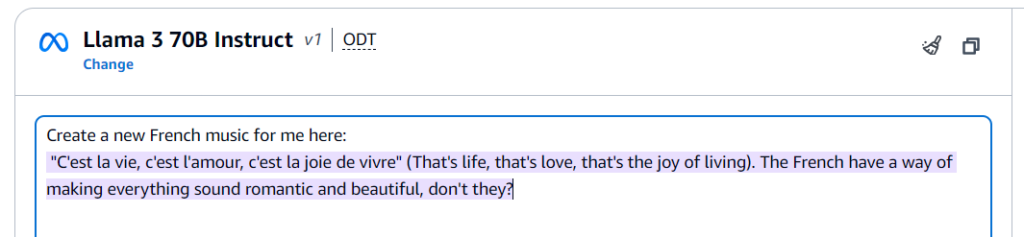

Et nous pouvons donner au modèle une invite pour le tester :

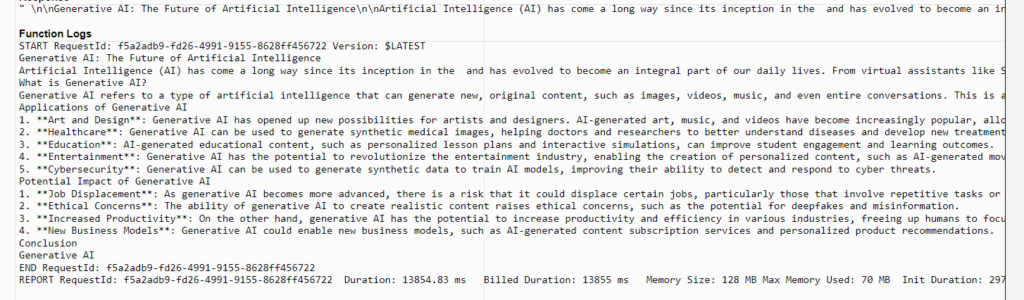

Maintenant, pour un cas d'utilisation plus réel, nous allons créer une fonction AWS Lambda et accéder au modèle à travers le API Bedrock.

Après avoir créé la fonction, nous devons lui donner la permission d'accéder à Bedrock, qui est "bedrock:InvokeModelWithResponseStream". Nous devons également augmenter la durée d'exécution de la fonction par défaut de 3 secondes à 1 minute (bien plus qu'il n'en faut pour que Bedrock renvoie la sortie du modèle).

Nous utiliserons ce code en python pour demander le modèle. Si vous utilisez un modèle différent de Llama 3 70B ou une autre région, n'oubliez pas de changer les paramètres.

En ce qui concerne les paramètres que j'ai utilisé dans la requête :

- prompt : Le texte pour lequel vous souhaitez que le modèle génère une réponse.

- max_gen_len : La longueur maximale du texte généré

- temperature : Contrôle le caractère aléatoire de la sortie. Des valeurs plus faibles rendent la sortie plus déterministe.

- top_p : Contrôle la probabilité cumulative pour la sélection des jetons. Elle permet de contrôler la diversité du texte généré.

Et si nous testons la fonction :

N'hésitez pas à jouer avec l'invite et les paramètres pour améliorer vos résultats.

Conclusion sur AWS Bedrock

Nous avons expliqué Amazon Bedrock et son fonctionnement, ainsi qu'une courte démo sur AWS Lambda. Nous avons montré à quel point il est facile de consommer des Modèles Fondamentaux sur AWS Bedrock et quelques possibilités d'utilisation.

Pour aller plus loin, vous pouvez utiliser les fonctionnalités d'Orchestration de Bedrock pour créer des applications d'IA plus complexes, nous écrirons bientôt un post à ce sujet !

Pour aller plus loin

Article - IA Générative : comment exploiter une base de connaissance avec RAG et AWS Bedrock ?

Webinar - Microsoft Copilot : comment passer à l'échelle vos cas d'usage ?